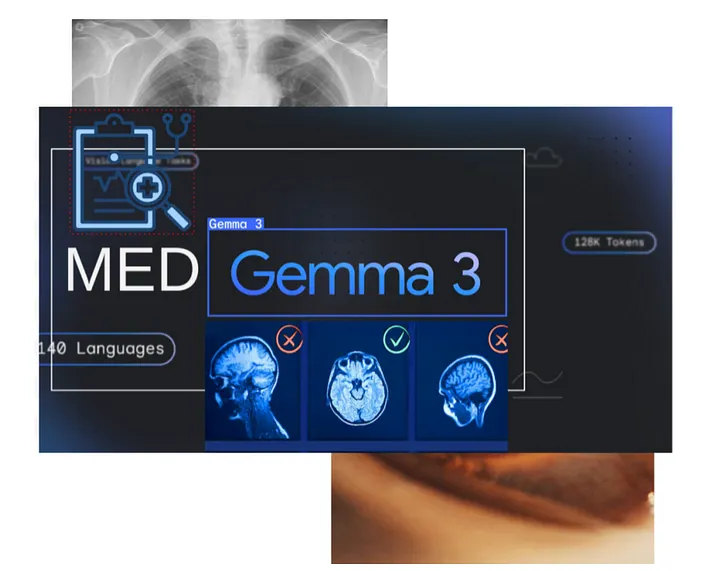

En el marco de Google I/O 2025, la compañía anunció MedGemma, una innovadora suite abierta de modelos diseñada para la comprensión multimodal de texto e imágenes médicas. Basada en la arquitectura Gemma 3, esta herramienta busca ofrecer a los desarrolladores una base sólida para la creación de aplicaciones de salud que integren análisis clínico tanto en datos visuales como textuales.

Variantes y arquitectura del modelo

MedGemma se presenta en dos configuraciones principales:

- MedGemma 4B: un modelo multimodal con 4 mil millones de parámetros, capaz de procesar simultáneamente imágenes médicas y texto. Integra un codificador de imágenes SigLIP, entrenado previamente en conjuntos de datos médicos desidentificados que incluyen radiografías de tórax, imágenes dermatológicas, de oftalmología y de histopatología. Su componente de lenguaje ha sido entrenado en datos médicos diversos, lo que le permite un entendimiento integral.

- MedGemma 27B: un modelo exclusivamente de texto con 27 mil millones de parámetros, optimizado para tareas de comprensión profunda de lenguaje médico y razonamiento clínico. Esta variante está ajustada mediante instrucciones y se orienta a aplicaciones que demandan un análisis textual avanzado.

Accesibilidad y despliegue

Los desarrolladores pueden acceder a los modelos MedGemma a través de Hugging Face, siempre que acepten los términos de uso de Health AI Developer Foundations. Además, los modelos pueden ejecutarse de forma local para experimentación o desplegarse como endpoints escalables vía Vertex AI en Google Cloud, lo que permite aplicaciones en entornos de producción.

Google también ofrece recursos de apoyo, como cuadernos en Colab, para facilitar la personalización, el ajuste fino y la integración en diferentes flujos de trabajo.

Aplicaciones y casos de uso

MedGemma está diseñado para servir como modelo base en una amplia gama de aplicaciones médicas:

- Clasificación de imágenes médicas: gracias al entrenamiento del modelo 4B, resulta útil en la clasificación de radiografías, imágenes dermatológicas y otros estudios visuales.

- Interpretación de imágenes médicas: puede generar reportes o responder preguntas sobre imágenes clínicas, apoyando los procesos de diagnóstico.

- Análisis de texto clínico: el modelo 27B se destaca en la comprensión y resumen de notas médicas, lo que facilita tareas como la clasificación de pacientes y el soporte a la toma de decisiones.

Adaptación y personalización

Aunque MedGemma ofrece un rendimiento sólido desde el inicio, Google recomienda validar y ajustar los modelos según el caso de uso específico. Para ello, los desarrolladores pueden emplear estrategias como prompt engineering, aprendizaje en contexto e incluso métodos de ajuste eficientes como LoRA. La compañía proporciona guías y herramientas que permiten potenciar el desempeño en escenarios clínicos concretos.

Con MedGemma, Google da un paso importante hacia la democratización de la inteligencia artificial médica. Al combinar capacidades multimodales, escalabilidad y opciones de adaptación, este conjunto de modelos se perfila como un recurso clave para impulsar aplicaciones de salud más avanzadas, integrando de manera fluida el análisis de texto clínico y de imágenes médicas.